На подходе новое семейство моделей искусственного интеллекта, и оно одно из немногих, которые можно воспроизвести с нуля.

Во вторник Ai2, некоммерческая исследовательская организация в области искусственного интеллекта, основанная покойным Полом Алленом, выпустила OLMo 2, второе семейство моделей в своей серии OLMo. (OLMo — сокращение от «Open Language Model».) Хотя нет недостатка в «открытых» языковых моделях на выбор (см.: Meta's Llama), OLMo 2 соответствует определению Open Source Initiative ИИ с открытым исходным кодом, что означает используемые инструменты и данные. для его разработки находятся в открытом доступе.

Инициатива открытого исходного кода, давно существующая организация, целью которой является определение и «управление» всем, что связано с открытым исходным кодом, в октябре завершила разработку своего определения ИИ с открытым исходным кодом. Но первые модели OLMo, выпущенные в феврале, также соответствовали этому критерию.

«OLMo 2 (был) разработан от начала до конца с открытыми и доступными данными обучения, кодом обучения с открытым исходным кодом, воспроизводимыми рецептами обучения, прозрачными оценками, промежуточными контрольными точками и многим другим», — написал AI2 в своем блоге. «Открыто делясь нашими данными, рецептами и выводами, мы надеемся предоставить сообществу открытого исходного кода ресурсы, необходимые для открытия новых и инновационных подходов».

В семействе OLMo 2 есть две модели: одна с 7 миллиардами параметров (OLMo 7B) и одна с 13 миллиардами параметров (OLMo 13B). Параметры примерно соответствуют навыкам решения проблем модели, а модели с большим количеством параметров обычно работают лучше, чем модели с меньшим количеством параметров.

Как и большинство языковых моделей, OLMo 2 7B и 13B могут выполнять ряд текстовых задач, таких как ответы на вопросы, обобщение документов и написание кода.

Для обучения моделей Ai2 использовал набор данных из 5 триллионов токенов. Токены представляют собой биты необработанных данных; 1 миллион токенов равен примерно 750 000 слов. Набор для обучения включал в себя веб-сайты, «отфильтрованные по высокому качеству», научные статьи, дискуссионные форумы вопросов и ответов и рабочие тетради по математике, «как синтетические, так и созданные человеком».

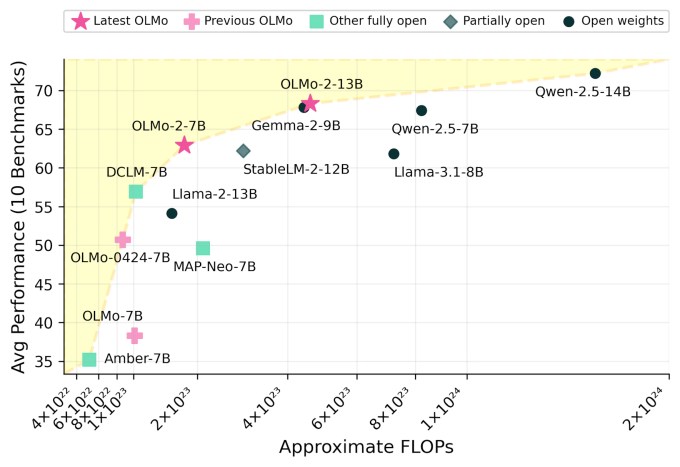

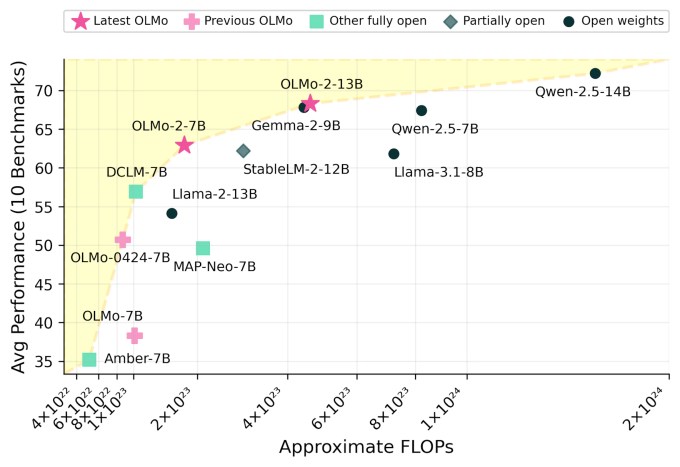

Ai2 утверждает, что результатом являются модели, конкурентоспособные с точки зрения производительности, с открытыми моделями, такими как версия Llama 3.1 от Meta.

«Мы не только наблюдаем резкое улучшение производительности во всех задачах по сравнению с нашей более ранней моделью OLMo, но, в частности, OLMo 2 7B превосходит LLama 3.1 8B», — пишет Ai2. «OLMo 2 (представляет) лучшие на сегодняшний день полностью открытые языковые модели».

Модели OLMo 2 и все их компоненты можно загрузить с веб-сайта Ai2. Они находятся под лицензией Apache 2.0, что означает, что их можно использовать в коммерческих целях.

Недавно были некоторые дебаты по поводу безопасности открытых моделей, в том числе моделей ламы, которые, как сообщается, используются китайскими исследователями для разработки инструментов защиты. Когда в феврале я спросил инженера Ai2 Дирка Гроенвельда, обеспокоен ли он злоупотреблениями OLMo, он сказал мне, что, по его мнению, польза в конечном итоге перевешивает вред.

«Да, возможно, открытые модели могут быть использованы ненадлежащим образом или в непредназначенных целях», — сказал он. «(Однако этот) подход также способствует техническому прогрессу, который ведет к созданию более этических моделей; является обязательным условием для проверки и воспроизводимости, поскольку этого можно достичь только при наличии доступа к полному набору данных; и уменьшает растущую концентрацию власти, создавая более справедливый доступ».