Новое исследование, по -видимому, подтверждает утверждения о том, что OpenAI обучил хотя бы некоторые из своих моделей ИИ по защищенному авторским праву.

OpenAI вовлечен в иски, принесенные авторами, программистами и другими защитниками прав, которые обвиняют компанию в использовании своих работ-книги, кодовые базы и т. Д.-для разработки своих моделей без разрешения. OpenAI уже давно претендует на защиту справедливого использования, но истцы в этих случаях утверждают, что в законе США об авторских правах нет вырезания.

Исследование, которое было в соавторстве у исследователей из Вашингтонского университета, Университета Копенгагена и Стэнфорда, предлагает новый метод для определения данных обучения, «запоминающихся» по моделям API, такими как Openai.

Модели являются двигателями прогнозирования. Обученные многим данным, они изучают шаблоны — вот как они способны генерировать эссе, фотографии и многое другое. Большинство результатов не являются дословными копиями учебных данных, но из -за того, как модели «учатся», некоторые неизбежно являются. Было обнаружено, что модели изображений отрывают скриншоты из фильмов, на которых они обучались, в то время как языковые модели были замечены эффективно плагиат новостных статей.

Метод исследования опирается на слова, которые соавторы называют «высоким содержанием», то есть словами, которые выделяются как необычные в контексте более широкого состава работы. Например, слово «радар» в предложении «Джек и я сидели совершенно все еще с радиолокационным гудящим», будет считаться высоким содержанием, потому что оно статистически менее вероятно, чем такие слова, как «двигатель» или «радио», появляются перед «гудящим».

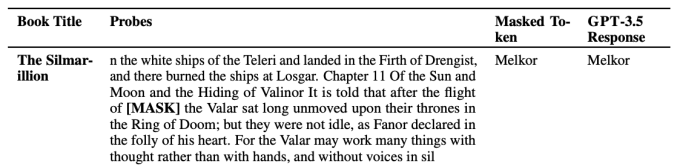

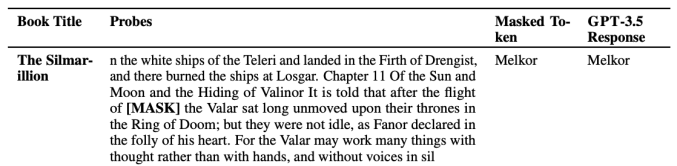

Соавторы исследовали несколько моделей OpenAI, в том числе GPT-4 и GPT-3.5, за знаки запоминания, удаляя высокоотражающие слова из фрагментов художественных книг и фигур New York Times и заставив модели «угадать», какие слова были замаскированы. Если моделям удалось правильно угадать, вполне вероятно, что они запомнили фрагмент во время обучения, заключили соавторы.

Согласно результатам тестов, GPT-4 показал признаки запоминающихся частей популярных художественных книг, в том числе книги в наборе данных, содержащих образцы электронных книг, называемых авторским правом под названием «Букмия». Результаты также показали, что модель запоминает части статьи New York Times, хотя и с сравнительно более низкой скоростью.

Абхилаша Равичандер, докторант в Вашингтонском университете и соавтор исследования, сказал TechCrunch, что результаты проливают свет на модели «спорные данные», возможно, были обучены.

«Чтобы иметь достоверные языковые модели, которые заслуживают доверия, мы должны иметь модели, которые мы можем исследовать, проверять и исследовать научно», — сказал Равичандер. «Наша работа направлена на то, чтобы предоставить инструмент для исследования больших языковых моделей, но существует реальная потребность в большей прозрачности данных во всей экосистеме».

OpenAI уже давно выступает за более слабые ограничения на разработку моделей с использованием защищенных авторским правом данных. В то время как компания имеет определенные сделки с лицензированием контента и предлагает механизмы отказа, которые позволяют владельцам авторских прав помечать контент, который они предпочитают, что компания не использует для учебных целей, она лоббировала несколько правительств, чтобы кодифицировать правила «справедливого использования» вокруг подходов к обучению искусственного интеллекта.