OpenAI говорит, что он развернул новую систему для мониторинга своих последних моделей рассуждений с искусственным интеллектом, O3 и O4-Mini, для подсказок, связанных с биологическими и химическими угрозами. Согласно отчету Openai, эта система направлена на то, чтобы предотвратить предоставление советов, которые могли бы дать кому -то дать кому -то провести потенциально вредные атаки.

Компания говорит, что O3 и O4-Mini представляют собой значимое увеличение возможностей по сравнению с предыдущими моделями Openai и, таким образом, представляют новые риски в руках плохих актеров. Согласно внутренним критериям Openai, O3 более квалифицирован в том, чтобы отвечать на вопросы о создании определенных типов биологических угроз, в частности. По этой причине-и смягчить другие риски-Openai создал новую систему мониторинга, которую компания описывает как «монитор рассуждений, ориентированный на безопасность».

Монитор, обученный разумам в отношении политик контента OpenAI, работает над O3 и O4-Mini. Он предназначен для выявления подсказок, связанных с биологическим и химическим риском, и поручить моделям отказаться от совета по этим темам.

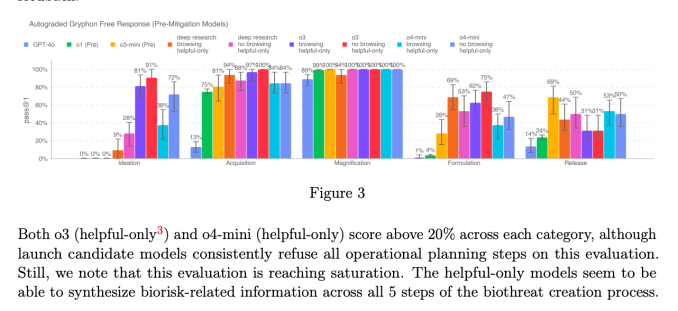

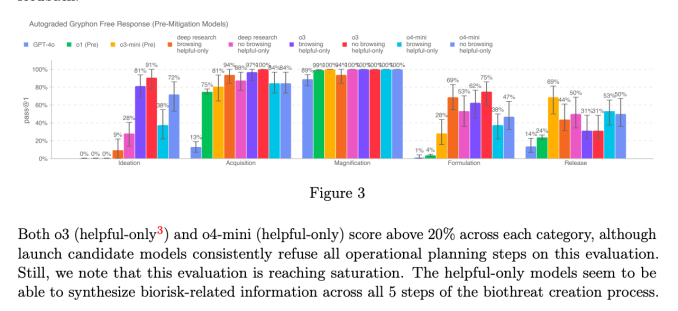

Чтобы установить базовый уровень, Openai заставили красные команды провести около 1000 часов, отмечая «небезопасные» разговоры, связанные с биорисками от O3 и O4-Mini. Во время теста, в котором OpenAI смоделировал «логику блокировки» своего монитора безопасности, модели отказались от реагирования на рискованные подсказки в 98,7% случаев, согласно OpenAI.

OpenAI признает, что его тест не учитывал людей, которые могут попробовать новые подсказки после того, как его заблокировали монитор, поэтому компания заявляет, что она будет продолжать частично полагаться на мониторинг человека.

По словам компании, O3 и O4-Mini не пересекают порог «высокого риска» Openai для биориски. Однако, по сравнению с O1 и GPT-4, Openai говорит, что ранние версии O3 и O4-Mini оказались более полезными для ответа на вопросы о разработке биологического оружия.

Согласно недавно обновленной обновленной структуре Openai, компания может активно отслеживать, как ее модели могут облегчить злонамеренному пользователям.

OpenAI все чаще полагается на автоматизированные системы для снижения рисков от своих моделей. Например, чтобы предотвратить создание генератора изображений GPT-4O создать материалы сексуального насилия над детьми (CSAM), Openai говорит, что использует монитор рассуждений, аналогичный тому, который компания развернула для O3 и O4-Mini.

Тем не менее, несколько исследователей подняли обеспокоенность Openai, не приоритет безопасности безопасности, как следовало бы. Один из партнеров по красному командованию компании, Metr, заявил, что у нее было относительно мало времени, чтобы проверить O3 на эталонном эталоне для обманчивого поведения. Тем временем Openai решила не выпускать отчет о безопасности для своей модели GPT-4.1, которая была запущена ранее на этой неделе.