На прошлогодней конференции AWS re:Invent подразделение облачных вычислений Amazon запустило SageMaker HyperPod, платформу для создания базовых моделей. Поэтому неудивительно, что на выставке re:Invent в этом году компания анонсирует ряд обновлений платформы, уделяя особое внимание тому, чтобы сделать обучение моделей и тонкую настройку HyperPod более эффективными и экономичными для предприятий.

HyperPod сейчас используется такими компаниями, как Salesforce, Thompson Reuters и BMW, а также такими стартапами в области искусственного интеллекта, как Luma, Perplexity, Stability AI и Hugging Face. Сегодняшние обновления AWS направлены на удовлетворение потребностей этих клиентов, рассказал мне Анкур Мехротра, генеральный директор, отвечающий за HyperPod в AWS.

Одна из проблем, с которыми сталкиваются эти компании, заключается в том, что зачастую им просто не хватает мощностей для выполнения рабочих нагрузок по обучению LLM.

«Часто из-за высокого спроса мощности могут быть дорогими, а также может быть трудно найти мощности тогда, когда они вам нужны, в том объеме, в котором они вам нужны, и именно там, где они вам нужны», — сказал Мехротра. «Тогда может случиться так, что вы обнаружите емкость в определенных блоках, которые могут быть разделены по времени и местоположению. Клиентам может потребоваться начать в одном месте, а затем перенести свою рабочую нагрузку в другое место и все такое, а затем также настроить и перезапустить свою инфраструктуру, чтобы делать это снова и снова».

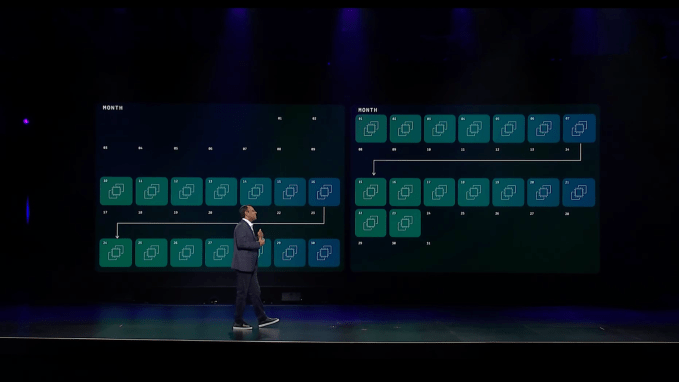

Чтобы упростить эту задачу, AWS запускает так называемые «гибкие планы обучения». Благодаря этому пользователи HyperPod могут установить сроки и бюджет. Допустим, они хотят завершить обучение модели в течение следующих двух месяцев и ожидают, что для этого потребуется 30 полных дней обучения с использованием определенного типа графического процессора. Затем SageMaker HyperPod может найти наилучшую комбинацию блоков емкости и разработать план, чтобы это произошло. SageMaker занимается выделением ресурсов инфраструктуры и запускает задания (и приостанавливает их, когда емкость недоступна).

В идеале, отметил Мехротра, это может помочь этим предприятиям избежать перерасхода средств за счет избыточного выделения серверов для своих обучающих работ.

Однако во многих случаях эти компании не обучают модели с нуля. Вместо этого они настраивают модели, используя свои собственные данные поверх моделей с открытым весом и модельных архитектур, таких как Llama от Meta. Для них команда SageMaker запускает HyperPod Recipes. Это проверенные и оптимизированные рецепты для распространенных архитектур, таких как Llama и Mistral, которые воплощают в себе лучшие практики использования этих моделей.

Мехротра подчеркнул, что эти рецепты также определяют правильную частоту контрольных точек для данной рабочей нагрузки, чтобы гарантировать регулярное сохранение прогресса тренировочной работы.

По мере роста числа команд, работающих с генеративным ИИ в компании, разные команды, скорее всего, будут выделять свои собственные мощности, что, в свою очередь, означает, что некоторые из этих графических процессоров будут простаивать и съедать общий бюджет компании на ИИ. Чтобы бороться с этим, AWS теперь позволяет предприятиям по существу объединять эти ресурсы и создавать центральный командный центр для распределения мощностей графических процессоров в зависимости от приоритета проекта. Затем система может автоматически распределять ресурсы по мере необходимости (или в соответствии с внутренней иерархией, которая не всегда может совпадать).

Еще одна возможность, которую это дает компаниям, заключается в том, что они могут использовать большую часть своих ресурсов для выполнения логических выводов в течение дня для обслуживания своих клиентов, а затем выделять больше этих ресурсов на обучение в ночное время, когда спрос на логические выводы меньше.

Как оказалось, AWS сначала создала эту возможность для самой Amazon, и благодаря этому новому инструменту компания увидела, что загрузка ее кластера превысила 90%.

«Организации действительно хотят инноваций, и у них очень много идей. Генеративный ИИ — это такая новая технология. Есть так много новых идей. И поэтому они сталкиваются с этими ресурсными и бюджетными ограничениями. Таким образом, речь идет о более эффективном выполнении работы, и мы действительно можем помочь клиентам сократить расходы — и это в целом помогает снизить затраты, как мы рассмотрели, до 40% для организаций».