По мере того как компании переходят от испытаний генеративного ИИ на ограниченных прототипах к их запуску в производство, они становятся все более внимательными к ценам. В конце концов, использование больших языковых моделей обходится недешево. Один из способов снизить затраты — вернуться к старой концепции: кэшированию. Другой вариант — направить более простые запросы к меньшим и более экономичным моделям. На своей конференции re:invent в Лас-Вегасе компания AWS сегодня анонсировала обе эти функции своего хостингового сервиса Bedrock LLM.

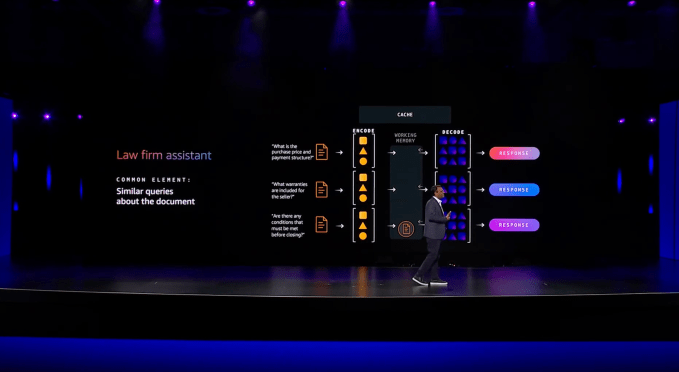

Давайте сначала поговорим о службе кэширования. «Предположим, есть документ, и несколько человек задают вопросы по одному и тому же документу. Каждый раз, когда вы платите», — рассказал мне Атул Део, директор по продукту Bedrock. «И эти контекстные окна становятся все длиннее и длиннее. Например, с Nova у нас будет 300 тысяч (токенов) контекста и 2 миллиона (токенов) контекста. Я думаю, что к следующему году этот показатель может даже подняться намного выше».

Кэширование, по сути, гарантирует, что вам не придется платить за то, чтобы модель выполняла повторяющуюся работу и повторно обрабатывала одни и те же (или по существу схожие) запросы снова и снова. По данным AWS, это может снизить затраты до 90%, но еще одним побочным результатом этого является то, что задержка получения ответа от модели значительно ниже (по данным AWS, до 85%). Adobe, которая тестировала оперативное кэширование для некоторых своих генеративных приложений искусственного интеллекта на Bedrock, добилась сокращения времени отклика на 72%.

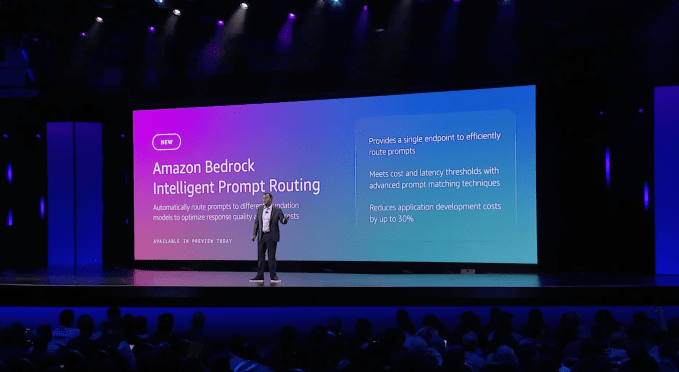

Другая важная новая функция — интеллектуальная маршрутизация подсказок для Bedrock. Благодаря этому Bedrock может автоматически перенаправлять запросы на разные модели одного и того же семейства, чтобы помочь предприятиям найти правильный баланс между производительностью и стоимостью. Система автоматически прогнозирует (используя небольшую языковую модель), как каждая модель будет работать для данного запроса, а затем соответствующим образом маршрутизирует запрос.

«Иногда мой вопрос может быть очень простым. Действительно ли мне нужно отправлять этот запрос на самую мощную модель, которая очень дорогая и медленная? Вероятно, нет. По сути, вы хотите создать идею «Эй, во время выполнения, на основе входящего запроса, отправьте правильный запрос к правильной модели», — объяснил Део.

Маршрутизация LLM, конечно, не новая концепция. Стартапы, такие как Martian, и ряд проектов с открытым исходным кодом также решают эту проблему, но AWS, вероятно, будет утверждать, что отличительной особенностью ее предложения является то, что маршрутизатор может интеллектуально направлять запросы без особого участия человека. Но он также ограничен тем, что может направлять запросы только к моделям в том же семействе моделей. Однако в долгосрочной перспективе, как рассказал мне Део, команда планирует расширить эту систему и предоставить пользователям больше возможностей настройки.

Наконец, AWS также запускает новую торговую площадку для Bedrock. Идея здесь, по словам Део, заключается в том, что, хотя Amazon сотрудничает со многими крупными поставщиками моделей, в настоящее время существуют сотни специализированных моделей, у которых может быть лишь несколько преданных пользователей. Поскольку эти клиенты просят компанию поддержать их, AWS запускает рынок для этих моделей, единственное существенное отличие которого заключается в том, что пользователям придется самостоятельно обеспечивать и управлять емкостью своей инфраструктуры — с чем Bedrock обычно справляется автоматически. В общей сложности AWS предложит около 100 таких новых и специализированных моделей, и в будущем их будет еще больше.