OpenAI движется, чтобы более регулярно опубликовать результаты своих внутренних оценок безопасности модели ИИ в более регулярной оценке в том, что наряд представляет собой попытку повысить прозрачность.

В среду Openai запустила Hub, веб -страницу, показывающую, как модели компании оценивают различные тесты для генерации вредного содержания, джейлбрейков и галлюцинаций. OpenAI говорит, что он будет использовать концентратор для обмена метриками на «постоянной основе», и что он намеревается обновить концентратор с помощью «Основных модельных обновлений» в будущем.

«По мере развития науки об оценке искусственного интеллекта мы стремимся поделиться нашим прогрессом в разработке более масштабируемых способов измерения возможностей и безопасности моделей», — написал OpenAI в посте в блоге. «Поделившись здесь подмножество наших результатов оценки безопасности, мы надеемся, что это не только облегчит понимание эффективности безопасности систем OpenAI с течением времени, но и поддержет усилия сообщества по повышению прозрачности по всей области».

OpenAI говорит, что он может добавить дополнительные оценки в центр с течением времени.

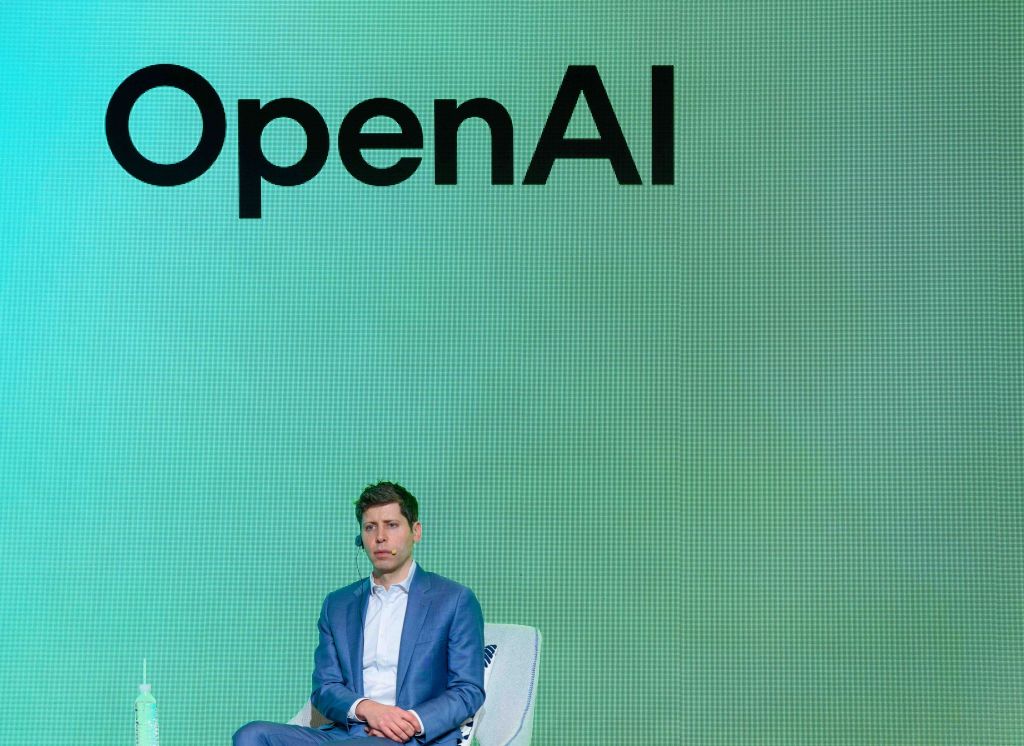

В последние месяцы OpenAI поднял гнев некоторых этиков за то, что он, как сообщается, бросила тестирование на безопасность определенных флагманских моделей и не выпустила технические отчеты для других. Генеральный директор компании, Сэм Альтман, также обвиняется в том, что он вводит в заблуждение руководителей Openai в отношении обзоров безопасности моделей до его краткого отставания в ноябре 2023 года.

В конце прошлого месяца Openai был вынужден отказаться от обновления модели по умолчанию, питающей CHATGPT, GPT-4O, после того, как пользователи начали сообщать, что она ответила чрезмерно подтверждающим и приятным способом. X стал затопленным скриншотами CHATGPT, аплодируя всевозможные проблемные, опасные решения и идеи.

OpenAI сказал, что в нем будет реализовать несколько исправлений и изменений для предотвращения будущих таких инцидентов, в том числе введение «альфа-фазы» для некоторых моделей, которые позволили бы определенным пользователям CHATGPT тестировать модели и дать обратную связь перед запуском.