Будьте в курсе бесплатных обновлений

Просто подпишитесь на Искусственный интеллект Myft Digest — доставлен непосредственно в ваш почтовый ящик.

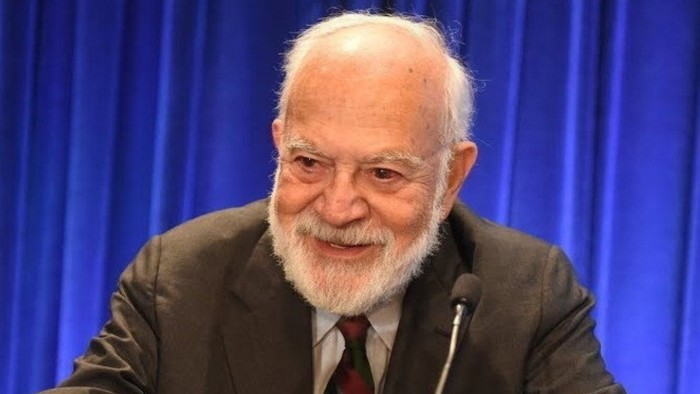

Ложь — не величайший враг истины, согласно философу Гарри Франкфурту. Чуть хуже.

Как он объяснил в своем классическом эссе На чушь (1986), лжец и истина, играют в одну и ту же игру, прямо на противоположных сторонах. Каждый реагирует на факты, поскольку они понимают их и либо принимают, либо отвергает авторитет истины. Но чушь игнорирует эти требования вообще. «Он не отвергает авторитет истины, как это делает лжец, и выступает против нее. Он вообще не обращает на это внимания. В силу этого чушь — более великий враг истины, чем ложь». Такой человек хочет убедить других, независимо от фактов.

К сожалению, Франкфурт умер в 2023 году, всего через несколько месяцев после выхода CHATGPT. Но чтение его эссе в эпоху генеративного искусственного интеллекта провоцирует тошнотворное знакомство. В некоторых отношениях эссе Франкфурта аккуратно описывает вывод моделей с поддержкой Ai-поддержки. Они не обеспокоены истиной, потому что у них нет концепции этого. Они работают по статистической корреляции, а не эмпирическим наблюдениям.

«Их величайшая сила, но и их самая большая опасность — это их способность звучать авторитетно практически по любой теме, независимо от фактической точности. Другими словами, их сверхдержава — их сверхчеловеческая способность к чушь, — написали Карл Бергстрем и Джевин Уэст. Два профессора Вашингтонского университета проводят онлайн-курс-современные оракулы или чушь, машины? — тщательно изучает эти модели. Другие переименовали выход машин как Botshit.

Одним из самых известных и тревожных, но иногда интересных творческих особенностей LLMS является их «галлюцинация» фактов-или просто создание чего-либо. Некоторые исследователи утверждают, что это неотъемлемая особенность вероятностных моделей, а не ошибка, которую можно исправить. Но компании ИИ пытаются решить эту проблему, улучшив качество данных, настраивая свои модели и создавая системы проверки и проверки фактов.

Похоже, что у них будет какое -то место, хотя, учитывая, что адвокат Антрии сообщил калифорнийскому суду в этом месяце, что их юридическая фирма само по себе непреднамеренно представила неверную цитату, галлюцинированную Claude компании ИИ. В качестве флага Google Chatbot для пользователей: «Близнецы могут совершать ошибки, в том числе о людях, так что дважды проверить это». Это не остановило Google с этой недели, развернув «режим AI» для всех его основных сервисов в США.

Способность этих компаний пытается улучшить свои модели, в том числе обучение подкреплению от отзывов человека, сам по себе рискуют ввести предвзятость, искажения и неопровержимые оценки стоимости. Как показал FT, AI Chatbots от Openai, Anpropic, Google, Meta, Xai и DeepSeek описывают качества руководителей своих собственных компаний и соперников совсем по -разному. Грок Элона Маск также продвигал мемы о «белом геноциде» в Южной Африке в ответ на совершенно не связанные с собой подсказки. Xai сказал, что он исправил сбой, который он обвинил в «несанкционированной модификации».

Такие модели создают новую, еще худшую категорию потенциального вреда — или «небрежная речь», по словам Сандры Вахтера, Брента Миттельштадта и Криса Рассела, в статье из Оксфордского интернет -института. По их мнению, небрежная речь может привести к нематериальному, долгосрочному и кумулятивному вреду. Это как «невидимая чушь», которая делает общество тупее, говорит мне Вахтер.

По крайней мере, с политиком или продавцом, мы обычно можем понять их мотивацию. Но чат -боты не имеют намеренности и оптимизированы для правдоподобия и взаимодействия, а не правдивости. Они будут изобретать факты без цели. Они могут загрязнять базу знаний человечества непостижимыми способами.

Интригующий вопрос заключается в том, могут ли модели ИИ быть разработаны для высшей правдивости. Будет ли рыночный спрос на них? Или модели должны быть вынуждены соблюдать более высокие стандарты истины, например, применить к рекламодателям, адвокатам и врачам? Вахтер предполагает, что разработка более правдивых моделей потребует времени, денег и ресурсов, которые предназначены для экономии текущих итераций. «Это похоже на то, чтобы хотеть, чтобы машина была самолетом. Вы можете оттолкнуть машину со скалы, но это не бросит вызов гравитации», — говорит она.

Все, что сказано, генеративные модели ИИ могут быть полезными и ценными. Многие прибыльные бизнеса — и политическая карьера были построены на чушь. Соответственно, генеративный ИИ может быть развернут для множества вариантов использования бизнеса. Но это бредовое и опасное, ошибаться в этих моделях за машины истины.

John.thornhill@ft.com