Возможно ли обучение ИИ только на данных, сгенерированных другим ИИ? Это может показаться безумной идеей. Но он существует уже довольно давно, и поскольку новые, реальные данные получить становится все труднее, он набирает обороты.

Anthropic использовала синтетические данные для обучения одной из своих флагманских моделей — Claude 3.5 Sonnet. Meta доработала свои модели Llama 3.1, используя данные, сгенерированные искусственным интеллектом. Говорят, что OpenAI получает данные синтетического обучения из o1, своей модели «рассуждения», для будущего Orion.

Но зачем ИИ вообще нужны данные – и что добрый данных, которые ему нужны? И могут ли эти данные Действительно заменить синтетическими данными?

Важность аннотаций

Системы искусственного интеллекта — это статистические машины. Обучившись на множестве примеров, они изучают закономерности в этих примерах, чтобы делать прогнозы, например, фраза «кому» в электронном письме обычно предшествует «это может касаться».

Аннотации, обычно текстовые, обозначающие значение или части данных, которые принимают эти системы, являются ключевым элементом в этих примерах. Они служат ориентирами, «учат» модель различать вещи, места и идеи.

Рассмотрим модель фотоклассификации, в которой представлено множество фотографий кухонь, помеченных словом «кухня». По мере обучения модель начнет создавать ассоциации между «кухней» и общими понятиями. характеристики кухонь (например, наличие холодильников и столешниц). После обучения, имея фотографию кухни, которая не была включена в первоначальные примеры, модель должна быть в состоянии идентифицировать ее как таковую. (Конечно, если бы изображения кухонь были помечены как «корова», это бы идентифицировало их как коров, что подчеркивает важность хороших аннотаций.)

Аппетит к ИИ и необходимость предоставления маркированных данных для его развития привели к раздуванию рынка услуг аннотаций. По оценкам Dimension Market Research, сегодня он стоит 838,2 миллиона долларов, а в ближайшие 10 лет будет стоить 10,34 миллиарда долларов. Хотя точных оценок количества людей, занимающихся маркировкой, нет, в документе 2022 года эта цифра исчисляется «миллионами».

Большие и малые компании полагаются на работников, нанятых фирмами, занимающимися аннотациями данных, для создания этикеток для обучающих наборов ИИ. Некоторые из этих работ оплачиваются достаточно хорошо, особенно если маркировка требует специальных знаний (например, математических знаний). Другие могут быть непосильными. Аннотаторам в развивающихся странах платят в среднем всего несколько долларов в час, без каких-либо льгот или гарантий будущих выступлений.

Высыхающий колодец данных

Итак, есть гуманистические причины искать альтернативу ярлыкам, созданным человеком. Например, Uber расширяет свой штат сотрудников для работы над аннотациями ИИ и маркировкой данных. Но есть и практичные.

Люди могут только так быстро навешивать ярлыки. Аннотаторы также имеют предвзятость, которая может проявляться в их аннотациях и, следовательно, в любых моделях, обученных на них. Аннотаторы допускают ошибки или запутываются в инструкциях по маркировке. А платить людям за то, чтобы они что-то делали, обходится дорого.

Данные в общем это дорого, кстати. Shutterstock взимает с поставщиков ИИ десятки миллионов долларов за доступ к своим архивам, в то время как Reddit заработал сотни миллионов на предоставлении лицензий Google, OpenAI и другим компаниям.

Наконец, становится все труднее получать данные.

Большинство моделей обучаются на огромных коллекциях общедоступных данных — данных, которые владельцы все чаще предпочитают скрывать из-за опасений, что их данные будут заимствованы или что они не получат за них должного признания или указания авторства. Более 35% из 1000 крупнейших веб-сайтов мира теперь блокируют веб-скребок OpenAI. Согласно одному недавнему исследованию, около 25% данных из «высококачественных» источников были исключены из основных наборов данных, используемых для обучения моделей.

Если текущая тенденция блокировки доступа сохранится, исследовательская группа Epoch AI прогнозирует, что у разработчиков закончатся данные для обучения генеративных моделей ИИ в период с 2026 по 2032 год. заставила поставщиков ИИ расплатиться.

Синтетические альтернативы

На первый взгляд может показаться, что синтетические данные являются решением всех этих проблем. Нужны аннотации? Сгенерируйте их. Больше примеров данных? Без проблем. Небо — это предел.

И в определенной степени это правда.

«Если «данные — это новая нефть», то синтетические данные позиционируются как биотопливо, которое можно создать без негативных внешних последствий, присущих реальным вещам», — сказал TechCrunch Ос Киз, кандидат наук в Вашингтонском университете, изучающий этическое воздействие новых технологий. . «Вы можете взять небольшой стартовый набор данных, смоделировать и экстраполировать на его основе новые записи».

Индустрия искусственного интеллекта взяла эту концепцию и начала ее реализовывать.

В этом месяце Writer, компания, специализирующаяся на генеративном искусственном интеллекте, представила модель Palmyra X 004, почти полностью обученную на синтетических данных. По словам Writer, его разработка обошлась всего в 700 000 долларов — по сравнению с оценкой в 4,6 миллиона долларов за модель OpenAI сопоставимого размера.

Открытые модели Microsoft Phi были обучены частично с использованием синтетических данных. То же самое можно сказать и о моделях Gemma от Google. Этим летом Nvidia представила семейство моделей, предназначенных для генерации синтетических обучающих данных, а AI-стартап Hugging Face недавно выпустил, по ее утверждению, самый большой набор синтетических текстов для обучения ИИ.

Генерация синтетических данных стала самостоятельным бизнесом, стоимость которого к 2030 году может составить 2,34 миллиарда долларов. Gartner прогнозирует, что 60% данных, используемых в проектах искусственного интеллекта и аналитики в этом году, будут генерироваться синтетически.

Лука Солдайни, старший научный сотрудник Института искусственного интеллекта Аллена, отметил, что методы синтетических данных можно использовать для генерации обучающих данных в формате, который нелегко получить с помощью парсинга (или даже лицензирования контента). Например, при обучении своего видеогенератора Movie Gen компания Meta использовала Llama 3 для создания титров к кадрам в обучающих данных, которые люди затем уточняли, добавляя больше деталей, например, описания освещения.

В том же духе OpenAI заявляет, что она настроила GPT-4o, используя синтетические данные, для создания функции Canvas, похожей на блокнот, для ChatGPT. А Amazon заявила, что генерирует синтетические данные в дополнение к реальным данным, которые она использует для обучения моделей распознавания речи для Alexa.

«Модели синтетических данных можно использовать для быстрого расширения человеческого понимания того, какие данные необходимы для достижения определенного поведения модели», — сказал Солдайни.

Синтетические риски

Однако синтетические данные не являются панацеей. Он страдает от той же проблемы «мусор на входе и выходе», что и весь ИИ. Модели создавать синтетические данные, и если данные, используемые для обучения этих моделей, имеют предвзятости и ограничения, их результаты будут аналогичным образом испорчены. Например, группы, плохо представленные в базовых данных, будут таковыми и в синтетических данных.

«Проблема в том, что вы можете сделать очень многое», — сказал Киз. «Предположим, в наборе данных у вас всего 30 чернокожих людей. Экстраполяция может помочь, но если все эти 30 человек принадлежат к среднему классу или все светлокожие, именно так будут выглядеть «репрезентативные» данные».

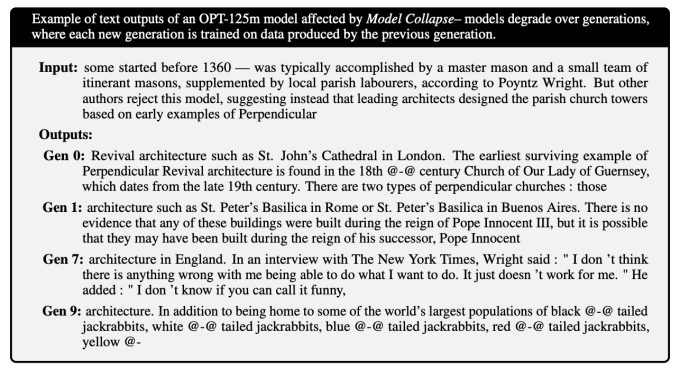

К этому моменту исследование, проведенное в 2023 году исследователями из Университета Райса и Стэнфорда, показало, что чрезмерная зависимость от синтетических данных во время обучения может создавать модели, «качество или разнообразие которых постепенно снижается». По мнению исследователей, смещение выборки — плохое представление реального мира — приводит к ухудшению разнообразия модели после нескольких поколений обучения (хотя они также обнаружили, что смешивание небольшого количества реальных данных помогает смягчить это).

Киз видит дополнительные риски в сложных моделях, таких как o1 OpenAI, которая, по его мнению, может вызывать галлюцинации, которые сложнее обнаружить в синтетических данных. Это, в свою очередь, может снизить точность моделей, обученных на данных, особенно если источники галлюцинаций определить непросто.

«Сложные модели галлюцинируют; данные, полученные с помощью сложных моделей, содержат галлюцинации», — добавил Киз. «А с такой моделью, как o1, сами разработчики не обязательно могут объяснить, почему появляются артефакты».

Усугубление галлюцинаций может привести к моделям, извергающим тарабарщину. Исследование, опубликованное в журнале Nature, показывает, как модели, обученные на данных, содержащих ошибки, генерируют даже больше данные, полные ошибок, и как эта петля обратной связи ухудшает качество будущих поколений моделей. Исследователи обнаружили, что модели теряют понимание более эзотерических знаний с течением времени, становясь более общими и часто давая ответы, не имеющие отношения к вопросам, которые им задают.

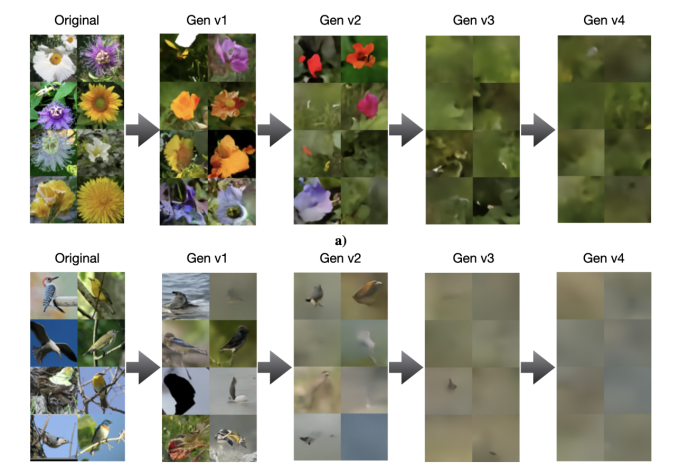

Последующее исследование показывает, что другие типы моделей, такие как генераторы изображений, не застрахованы от такого рода коллапса:

Солдайни согласен, что «необработанным» синтетическим данным нельзя доверять, по крайней мере, если цель состоит в том, чтобы избежать обучения забывчивых чат-ботов и генераторов однородных изображений. «Безопасное» использование, по его словам, требует тщательного анализа, обработки и фильтрации, а в идеале — сопоставления со свежими реальными данными — точно так же, как вы делаете это с любым другим набором данных.

Невыполнение этого требования может в конечном итоге привести к краху модели, когда модель станет менее «творческой» — и более предвзятой — в своих результатах, что в конечном итоге серьезно поставит под угрозу ее функциональность. Хотя этот процесс можно выявить и остановить до того, как он станет серьезным, это риск.

«Исследователям необходимо изучить сгенерированные данные, повторить процесс генерации и определить меры безопасности для удаления некачественных данных», — сказал Солдайни. «Синтетические конвейеры данных не являются самосовершенствующейся машиной; их результаты должны быть тщательно проверены и улучшены, прежде чем использоваться для обучения».

Генеральный директор OpenAI Сэм Альтман однажды заявил, что когда-нибудь ИИ будет производить синтетические данные, достаточно хорошие для эффективного обучения. Но — если предположить, что это вообще осуществимо — такой технологии пока не существует. Ни одна крупная лаборатория искусственного интеллекта не выпустила обученную модель только на синтетических данных.

По крайней мере, в обозримом будущем нам, похоже, понадобятся люди. где-то чтобы убедиться, что обучение модели не пойдет наперекосяк.

У TechCrunch есть информационный бюллетень, посвященный искусственному интеллекту! Зарегистрируйтесь здесь чтобы получать его на свой почтовый ящик каждую среду.

Обновление: эта история была первоначально опубликована 23 октября и обновлена 24 декабря с добавлением дополнительной информации.