Генеральный директор Nvidia Дженсен Хуанг говорит, что производительность ИИ-чипов его компании растет быстрее, чем исторические темпы, установленные законом Мура, который десятилетиями способствовал прогрессу вычислений.

«Наши системы развиваются намного быстрее, чем закон Мура», — сказал Хуанг в интервью TechCrunch во вторник, на следующее утро после того, как он выступил с программной речью перед 10-тысячной толпой на выставке CES в Лас-Вегасе.

Закон Мура, придуманный соучредителем Intel Гордоном Муром в 1965 году, предсказывал, что количество транзисторов в компьютерных чипах будет примерно удваиваться каждый год, что фактически удваивает производительность этих чипов. Этот прогноз в основном оправдался и привел к быстрому увеличению возможностей и резкому снижению затрат на десятилетия.

В последние годы действие закона Мура замедлилось. Однако Хуанг утверждает, что ИИ-чипы Nvidia сами по себе развиваются ускоренными темпами; Компания заявляет, что ее последний суперчип для центров обработки данных более чем в 30 раз быстрее выполняет рабочие нагрузки искусственного интеллекта, чем его предыдущее поколение.

«Мы можем создавать архитектуру, чип, систему, библиотеки и алгоритмы одновременно», — сказал Хуанг. «Если вы сделаете это, то сможете двигаться быстрее, чем закон Мура, потому что вы сможете внедрять инновации во всем стеке».

Смелое заявление генерального директора Nvidia прозвучало в то время, когда многие задаются вопросом, застопорился ли прогресс ИИ. Ведущие лаборатории искусственного интеллекта, такие как Google, OpenAI и Anthropic, используют чипы искусственного интеллекта Nvidia для обучения и запуска своих моделей искусственного интеллекта, и развитие этих чипов, вероятно, приведет к дальнейшему прогрессу в возможностях моделей искусственного интеллекта.

Хуан отвергает идею о том, что прогресс ИИ замедляется. Вместо этого он утверждает, что сейчас действуют три действующих закона масштабирования ИИ: предварительное обучение, начальный этап обучения, на котором модели ИИ изучают закономерности на основе больших объемов данных; пост-обучение, которое точно настраивает ответы модели ИИ, используя такие методы, как обратная связь с человеком; и вычисления во время тестирования, которые происходят на этапе вывода и дают модели ИИ больше времени «подумать» после каждого вопроса.

«Закон Мура сыграл столь важную роль в истории вычислений, потому что он снизил затраты на вычисления», — сказал Хуанг TechCrunch. «То же самое произойдет и с логическим выводом: мы повысим производительность, и в результате стоимость вывода будет меньше».

(Конечно, благодаря буму искусственного интеллекта Nvidia стала самой ценной компанией на Земле, поэтому Хуангу выгодно так говорить.)

H100 от Nvidia были выбором технологических компаний, стремящихся обучать модели искусственного интеллекта, но теперь, когда технологические компании больше внимания уделяют выводам, некоторые задаются вопросом, останутся ли дорогие чипы Nvidia на вершине.

Модели искусственного интеллекта, использующие вычисления во время тестирования, сегодня обходятся дорого. Есть опасения, что модель OpenAI o3, в которой используется увеличенная версия вычислений во время тестирования, будет слишком дорогой для использования большинством людей. Например, OpenAI тратила около 20 долларов на задачу, используя o3 для достижения результатов на уровне человека в тесте на общий интеллект. Подписка ChatGPT Plus стоит 20 долларов США за целый месяц использования.

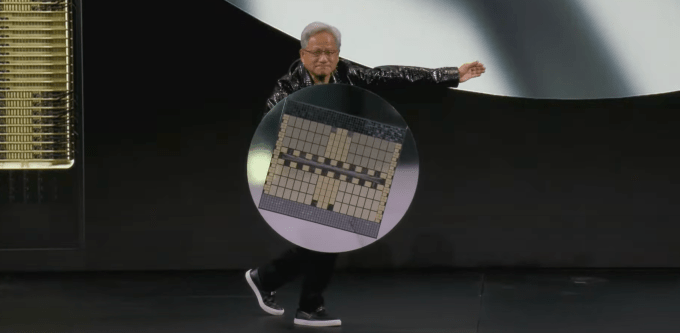

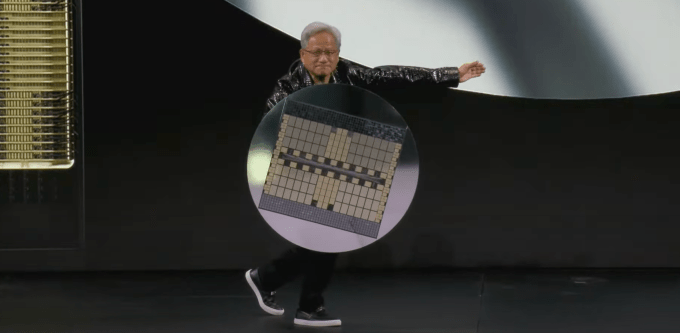

Во время выступления в понедельник Хуанг держал на сцене новейший суперчип Nvidia для центров обработки данных, GB200 NVL72, как щит. Этот чип в 30–40 раз быстрее выполняет рабочие нагрузки искусственного интеллекта, чем предыдущий бестселлер Nvidia — H100. Хуанг говорит, что этот скачок производительности означает, что модели рассуждения ИИ, такие как o3 от OpenAI, которая использует значительный объем вычислений на этапе вывода, со временем станут дешевле.

Хуанг говорит, что в целом он сосредоточен на создании более производительных чипов, и что более производительные чипы в долгосрочной перспективе приведут к снижению цен.

«Прямым и немедленным решением для вычислений во время тестирования, как с точки зрения производительности, так и с точки зрения доступности затрат, является увеличение наших вычислительных возможностей», — сказал Хуанг TechCrunch. Он отметил, что в долгосрочной перспективе модели рассуждения ИИ можно использовать для создания более качественных данных для предварительного и последующего обучения моделей ИИ.

Мы, конечно, стали свидетелями резкого падения цен на модели искусственного интеллекта в прошлом году, отчасти из-за компьютерных прорывов таких производителей оборудования, как Nvidia. Хуан говорит, что он ожидает продолжения этой тенденции в моделях рассуждений ИИ, хотя первые версии OpenAI, которые мы видели, были довольно дорогими.

В более широком смысле, Хуанг заявил, что его чипы искусственного интеллекта сегодня в 1000 раз лучше, чем те, которые он производил 10 лет назад. Это гораздо более высокие темпы, чем стандарт, установленный законом Мура, и Хуан говорит, что не видит признаков скорой остановки.