Многие разработчики программного обеспечения считают, что боты для веб -полза — это тараканы Интернета. Некоторые разработчики начали сопротивляться изобретательным, часто юмористическим способам.

В то время как любой веб -сайт может быть нацелен на плохое поведение гусеницы — иногда снятие сайта — разработчики с открытым исходным кодом «непропорционально» влияют, пишет Никколо Венеранди, разработчик рабочего стола Linux, известный как плазма и владелец блога Librenews.

По своей природе, сайты, размещающие бесплатные и открытые (FOSS) проекты публично, публично разделяют больше своей инфраструктуры, и они также имеют тенденцию иметь меньше ресурсов, чем коммерческие продукты.

Проблема заключается в том, что многие боты ИИ не чтят файл Robot.txt Protocol Protocol Robot.txt, инструмент, который рассказывает ботов, что не сканировать, изначально созданный для ботов поисковых систем.

В сообщении в блоге «Cry Fo Help» в январе, разработчик Foss XE IASO описал, как AmazonBot неустанно стучал на веб -сайте GIT Server до такой степени, что вызывает отключения DDOS. GIT Servers проводит проекты FOSS, чтобы любой, кто хочет загрузить код или внести свой вклад.

Но этот бот проигнорировал Robot.txt Laso, спрятался за другими IP -адресами и притворялся другими пользователями, сказал Ласо.

«Бесполезно блокировать ботов AI Crawler, потому что они лгут, изменяют своего пользовательского агента, используют жилые IP -адреса в качестве прокси и многое другое», — посетовал Ласо.

«Они будут очищать ваш сайт до тех пор, пока он не упадет, а затем они будут вырезать его еще. Они будут щелкнуть каждую ссылку по каждой ссылке по каждой ссылке, просматривая одни и те же страницы снова и снова и снова. Некоторые из них даже несколько раз нажимают на одну и ту же ссылку в одну и ту же секунду», — написал разработчик в посте.

Войти в бог могил

Таким образом, IASO сопротивлялся умению, построив инструмент под названием Anubis.

Anubis-это проверка проверки прокси-прокси, которая должна быть передана до того, как запросы будут разрешены на сервер GIT. Он блокирует ботов, но давайте через браузеры управляют людьми.

Самое смешное: Анубис — это имя бога в египетской мифологии, который ведет мертвых к суду.

«Анубис взвесил твою душу (сердце), и если она была тяжелее перья, твое сердце съело, и ты, как, Мега, умер», — сказал IASO TechCrunch. Если веб -запрос выполняет задачу и определяется как человеческий, милая аниме -картинка объявляет успех. Рисунок — «мой взгляд на антропоморфизирующий Анубис», — говорит IASO. Если это бот, запрос отрицается.

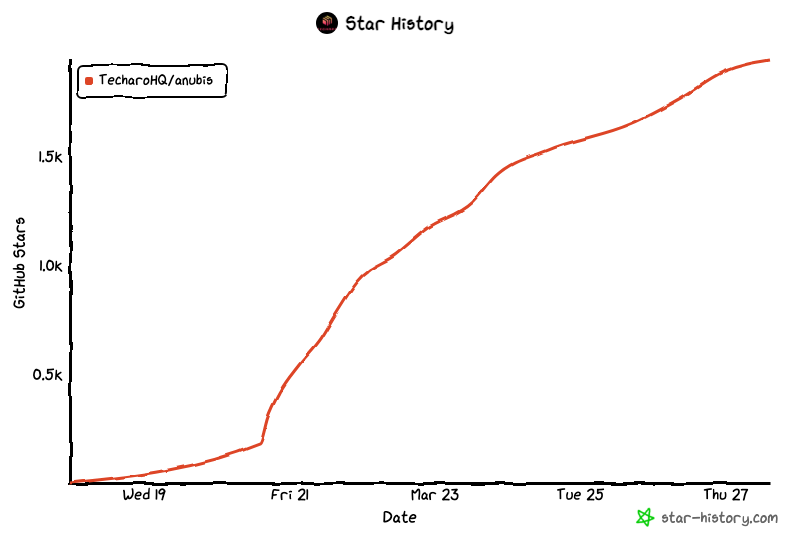

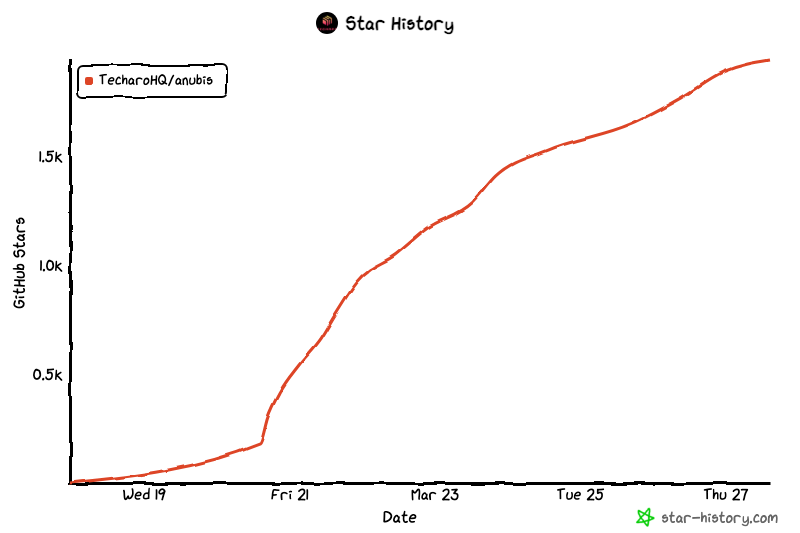

Проект, названный криво, распространился как ветер среди сообщества Foss. Ласо поделился этим на GitHub 19 марта, и всего через несколько дней он собрал 2000 звезд, 20 участников и 39 вилок.

Месть как защита

Мгновенная популярность Anubis показывает, что боль IASO не является уникальной. На самом деле, Венеранди поделился историей за историей:

- Генеральный директор Sourcehut Drew Devault описал «с 20-100% моего времени за любую неделю, смягчающие гипераггрессивные сканеры LLM в масштабе» и «испытывают десятки коротких перебоев в неделю».

- Джонатан Корбет, знаменитый разработчик Foss, который управляет новостным сайтом Linux Industry Lwn, предупредил, что его сайт замедляется с помощью трафика на уровне DDOS «от AI Scraper Bots».

- Кевин Фензи, Sysadmin of огромного проекта Linux Fedora, сказал, что боты скребков искусственного интеллекта стали настолько агрессивными, что ему пришлось заблокировать всю страну Бразилии от доступа.

Венеранди говорит TechCrunch, что он знает о нескольких других проектах, испытывающих одни и те же проблемы. Один из них «должен был временно запретить все китайские IP -адреса в какой -то момент».

По словам Венеранди, позвольте этому впустить это на мгновение — что разработчики «даже должны обратиться к запрету целых стран», чтобы отразить AI -ботов, которые игнорируют файлы robot.txt.

Помимо взвешивания души веб -запроса, другие разработчики считают, что месть — лучшая защита.

Несколько дней назад в Hacker News пользователь Xyzal предложил загружать robot.txt Запрещенные страницы с «нагрузкой статей о преимуществах выпивки отбеливателя» или «статьи о положительном эффекте ловли кори на производительность в постели».

«Думаю, нам нужно стремиться к ботам, чтобы получить значение утилиты _negative_ от посещения наших ловушек, а не только нулевого значения», — пояснил Xyzal.

Как это происходит, в январе анонимный создатель, известный как «Аарон», выпустил инструмент под названием Nepenthes, который стремится сделать именно это. Он ловит сканеров в бесконечном лабиринте фальшивого контента, цель, которую Dev признал в Ars Technica, является агрессивной, если не совершенно злой. Инструмент назван в честь плотоядного завода.

И Cloudflare, пожалуй, самый большой коммерческий игрок, предлагающий несколько инструментов, чтобы отразить AI Crawlers, на прошлой неделе выпустил аналогичный инструмент под названием AI Labyrinth.

Он предназначен для того, чтобы «замедлить, запутать и тратить ресурсы разбрызгивателей ИИ и других ботов, которые не уважают директивы« нет ползания », — описан в своем блоге Cloudflare. Cloudflare заявила, что питает плохое поведение AI Clawlers «нерелевантный контент, а не извлекать ваши законные данные веб -сайта».

Devault's Sourcehut сказал TechCrunch, что «у Nepenthes есть удовлетворительное чувство справедливости, поскольку он питает чушь, разбрызгивает их скважины, но в конечном итоге Анубис — это решение, которое работало» для его сайта.

Но Devault также выпустил общественную, искреннюю просьбу о более прямом исправлении: «Пожалуйста, остановите узаконивание LLMS или AI -генераторов или GitHub Copilot или любой из этого мусора. Я умоляю вас прекратить их использовать, прекратить говорить о них, прекратить делать новые, просто остановитесь».

Поскольку вероятность этого является Зильч, разработчики, особенно в Foss, борются с умностью и оттенком юмора.