OpenAI наконец-то представила возможности видео в реальном времени для ChatGPT, которые она продемонстрировала почти семь месяцев назад.

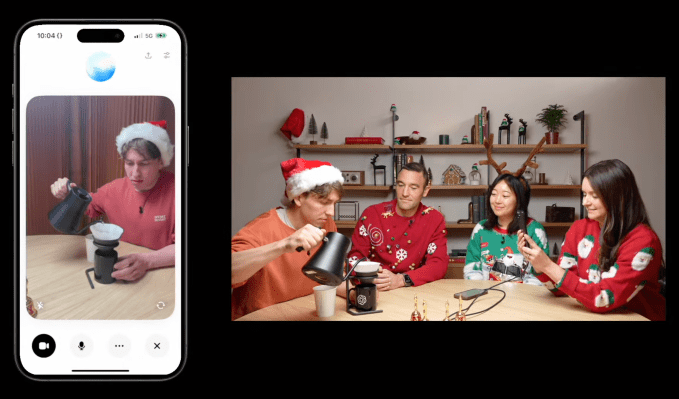

В четверг во время прямой трансляции компания заявила, что Advanced Voice Mode, ее человеческая разговорная функция для ChatGPT, получает видение. Используя приложение ChatGPT, пользователи, подписавшиеся на ChatGPT Plus, Team или Pro, могут направлять свои телефоны на объекты и получать ответ ChatGPT практически в реальном времени.

Расширенный голосовой режим с функцией Vision также может понимать, что происходит на экране устройства, посредством совместного использования экрана. Например, он может объяснить различные меню настроек или дать рекомендации по решению математической задачи.

Чтобы получить доступ к расширенному голосовому режиму с помощью Vision, коснитесь значка голоса рядом с панелью чата ChatGPT, затем коснитесь значка видео в левом нижнем углу, чтобы запустить видео. Чтобы поделиться экраном, коснитесь трехточечного меню и выберите «Поделиться экраном».

По словам OpenAI, внедрение расширенного голосового режима с Vision начнется в четверг и завершится на следующей неделе. Но не все пользователи получат доступ. OpenAI сообщает, что подписчики ChatGPT Enterprise и Edu не получат эту функцию до января, и что у нее нет сроков для пользователей ChatGPT в ЕС, Швейцарии, Исландии, Норвегии или Лихтенштейне.

В недавней демонстрации на канале CNN «60 минут» президент OpenAI Грег Брокман использовал расширенный голосовой режим с тестом на зрение Андерсона Купера, посвященного его навыкам анатомии. Когда Купер рисовал части тела на доске, ChatGPT мог «понять», что он рисовал.

«Местоположение идеальное», — сказал ChatGPT. «Мозг находится прямо в голове. Что касается формы, то это хорошее начало. Мозг больше похож на овал».

Однако в той же демонстрации расширенный голосовой режим со зрением допустил ошибку в задаче по геометрии, предполагая, что он склонен к галлюцинациям.

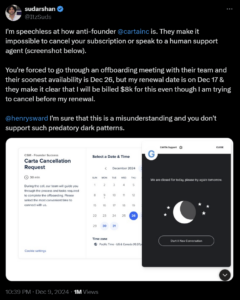

Расширенный голосовой режим со зрением несколько раз откладывался — как сообщается, отчасти потому, что OpenAI анонсировала эту функцию задолго до того, как она была готова к производству. В апреле OpenAI пообещала, что расширенный голосовой режим будет доступен пользователям «в течение нескольких недель». Спустя несколько месяцев компания заявила, что ей нужно больше времени.

Когда в начале осени расширенный голосовой режим наконец появился для некоторых пользователей ChatGPT, в нем отсутствовал компонент визуального анализа. В преддверии запуска в четверг OpenAI сосредоточила свое внимание на предоставлении расширенного голосового режима только для голосовой связи дополнительным платформам и пользователям в ЕС.

Конкуренты, такие как Google и Meta, работают над аналогичными возможностями для своих продуктов-чат-ботов. На этой неделе Google предоставила группе «доверенных тестировщиков» на Android свою функцию диалогового искусственного интеллекта Project Astra, анализирующую видео в реальном времени.

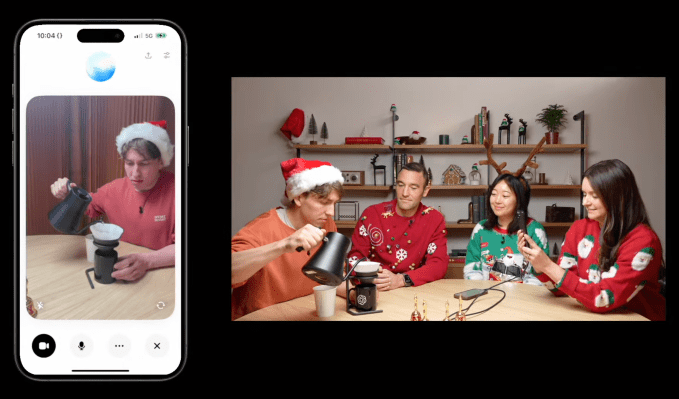

В дополнение к расширенному голосовому режиму с видением, OpenAI в четверг запустил праздничный «Режим Санты», который добавляет голос Санты в качестве предустановленного голоса в ChatGPT. Пользователи могут найти его, коснувшись или щелкнув значок снежинки в приложении ChatGPT рядом с панелью подсказок.